如何在培训后进行法律扩展?这是LLM训练后的摘

作者:BET356官网在线登录 发布时间:2025-05-03 14:18

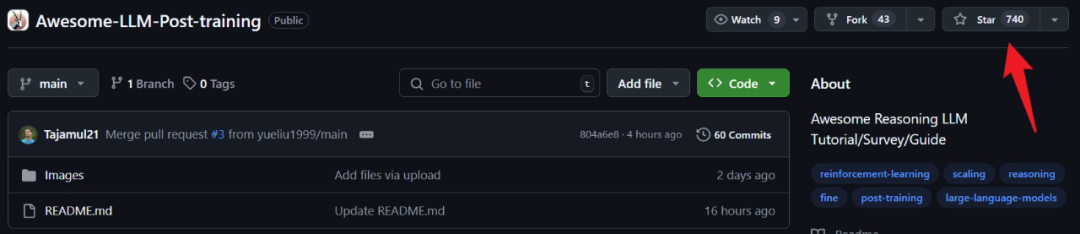

如今,培训后的技术(例如维修和增强研究)已成为提高LLM功能的重要关键。最近,一份后LLM培训审查报告获得了许多赞美,其用于分类的相关论文和工具的资源库已获得了700多颗恒星。 The review comes from various institutions including the UAE University of Artificial Intelligence, the University of Central Florida, Google Deepmind, and Oxford, which covers technologies that enhance LLM by studying reinforcement, administering fine-expanding, test-to-test-expansion, and testing of post---------------------------language training.纸张标题:LLM验证训练:大型语言模型推理的深入潜水:https://arxiv.org/abs/2502.21321资源库:https://github.com/mbzuai-ysomex/awsome-some-loweshome-awesome-awsome-lawsome-llm-post-post-训练机器在内容和内容上累积了一份内容。有关更多详细信息,请访问上面的链接。在rec多年来,大语言模型(LLM)的功能继续改善,应用领域也迅速扩大。尽管如此,仍然存在问题。例如,LLM可能具有这样的“幻觉”,即产生错误的内容或不正确的事实;在更长的会议上保持逻辑一致性也可能很难。此外,LLM中推理的概念仍然是一个高度辩论的主题。尽管理解模型可能会提供看似合乎逻辑的相互关联的响应,但它们的推理与作为人的逻辑推理不同。这种差异很重要,因为Nakit有助于解释为什么LLM在执行引人注目的输出时仍在与相对简单的逻辑作品作斗争。与操纵明确的政策和事实的象征性推理不同,LLM以隐式和概率的方式运作。在本综述报告中,LLM的“推理”是指基于统计模式的逻辑相互关联回答的形成在数据中,而不是明确的逻辑推理或符号操作。此外,在接下来的代币预测中训练的模型可能与用户期望或道德标准不符,尤其是在模糊或恶意情况下。这些问题表明,还需要专门的技术来解决LLM输出的可靠性,偏见和上下文敏感性问题。训练的过程几乎可以分为两个阶段:训练前和训练后。训练前阶段通常取决于下一个标记,从而预测目标的大规模语料库,而训练后阶段通常涉及许多精细修复和比对的旋转。训练后机制的目的是改善模型的行为,并通过优化模型行为来与人类意图(包括降低偏见和不准确)保持一致。为了使LLM适应某些活动领域,通常涉及诸如微调之类的方法。尽管这些技术CAn用于特定任务,但也存在过度拟合的风险,并且还具有高计算成本。为了解决这些困难,引入了加强研究(RL)。这使Modelo可以使用动态反馈和优化的决策来提高灵活性。此外,通过搜索(RAG)增强的缩放技术,包括低级别适应性(LORA),适配器和世代,还可以提高计算效率和现实的准确性。这些策略与共享培训框架结合使用,促进了大规模扩展,并进一步提高了各种应用中LLM的可用性,请参见下面的图1。通过针对性的训练后技术,LLM可以更好地与人类的意图和道德道德要求保持一致,这最终可以提高其在现实世界中的可用性。关键的训练后阶段摘要下面。该安排是为了使预训练的LLM适应特定的任务或字段,并具体方法是根据所选数据集更新参数。尽管在规模上进行培训的LLM通常具有良好的总体能力,但微调也可以增强其在特定活动中的能力,包括感性分析,问答和医学诊断。通常对此过程进行管理,这与模型与任务要求保持一致,但也带来了诸如过度拟合,高计算成本和数据偏见敏感性之类的困难。为此,诸如Lora和适配器之类的良好参数可以通过更新显式参数来找出特定任务,从而大大降低计算开销。尽管这些模型是专家,但他们可能会遇到外部外部暴力困难,为此,他们需要权衡模型的专业素养或使用。研究传统强化研究环境的强化,代理必须与结构化环境相互作用,采取离散的行动在状态之间,并最大程度地提高合并的-a-奖励。适合加固研究的领域应具有确定的状态 - 行动空间和明确的目标,例如机器人,棋盘游戏和控制系统。在LLM领域的加固研究是不同的。 LLM不是从有限的一组动作中选择的,而是从大型词汇中选择的,它们的新兴状态由成长的文本文本组成。这样,信贷的计划和提供将变得复杂,因为令牌选择的效果通常直到最后才出现。此外,基于语言的增强反馈的特征是稀疏,主观和延迟,因此通常依赖于启发式检查和用户偏好而不是明确的性能指标。与通常用于单一目的进行优化的传统加固研究不同,LLM还应平衡许多目标。一种结合基于过程的奖励的混合方法(例如推理之王)通过结果评估(例如,质量反应)有助于改善研究结果。因此,LLM增强研究需要特殊的优化技术来处理高维输出,不稳定的状态目标和复杂性结构,以确保响应保持上下文并与用户期望保持一致。扩展对于提高LLM的性能和效率至关重要。这将有助于提高活动中模型的整体模型的性能,但也可以带来重大的计算挑战。为了平衡绩效和资源效率,在推理时必须针对目标。诸如思想链(COT)推理和对树(TOT)框架的思考之类的方法通过在分步或类似结构中破坏复杂问题来增强推理的许多步骤。此外,基于搜索的技术可以迭代地探索可能的输出,有助于改善响应并确保REA的准确性提高爱。这些技术,结合了洛拉,适配器和抹布等方法,可以提高模型处理复杂的,特定领域的大型任务的能力。抹布可以通过动态新知识来提高精度,从而减轻静态培训数据限制。共享的培训框架可以利用并行处理来管理大型模型的高计算要求。测试时间延长可能会根据任务的复杂性来调整参数以优化识别。改变深度,宽度或活动层可以平衡计算效率和输出质量,以适应资源有限或可变的条件。尽管按比例抑制了颠簸,但仍然存在挑战,例如减少回报,更长的理解时间和环境影响,尤其是在测试过程中执行搜索技术而不是训练时。以高质量和良好的质量部署LLM,以确保访问D可行性很重要。背景信息审查报告的第二部分介绍了与后LLM培训有关的背景信息,包括基本的正式描述,基于加强研究的订单推理以及早期刺激语言建模方法。但是我们在这里跳过了,请查看原始报告以获取详细信息。表1提供了最近的模型的一般性 - 包括其参数,架构类型和所使用的蒸馏RL方法。图2总结了LLM推理方法,该方法显示了通过提示链(COT)提示,自回馈和情节记忆来增强推理能力的方法。它还展示了各种基于研究的优化技术,包括GRPO,RLHF,DPO和RLAIF。从一种过程中,加强律师事务所将增强措施整合到LLM推理的研究中,通常遵循以下基本步骤:1。微调管理(SFT):从前活语言开始DEL,在包含高质量的人造样品样本的管理数据集中的精细建模模型。此阶段确保模型获得符合格式和样式的基线。 2。模型模型(RM)训练:收集通过微调模型产生的输出并执行手动偏好。然后,对奖励模型进行训练以复制标签或基于等级的标记,从而有效地学习持续的奖励功能,该功能将文本响应映射到标量值。 3。研究研究研究研究:最后,通过策略梯度算法(例如PPO)优化基本语言模型,以最大程度地提高奖励模型的输出。通过避免通过此循环,LLM可以意识到在性,有用性和风格连贯性等基本方面有利于人类的更多响应的准确性。 4。维修和对齐的奖励:发展复杂的奖励功能(从人类的偏好,对抗反馈或自动措施中汲取),以指导ANG模型,以获得连贯,安全,安全,适当的上下文适当。在理解许多步骤的过程中,有效地提供信贷,这些奖励很重要。在早期,人类偏好的LLM研究算法是经典的算法,例如PPO和自信域(TRPO),这是通过最大化预期的合并 - 与 - 奖励和KL不同的优化技术。在这些过程中的改进后继者,例如直接偏好优化(DPO)和小组相对策略优化(GRPO),已经基于偏好而进行了可扩展优化。这些程序重新表达目标对准作为基于偏好数据标记人的维修的损失函数。与PPO和TRPO不同,依赖于明确的奖励模型和审查网络,DPO和GRPO使用对数加不出的比率以及删除组比较分别直接优化技术,以消除对显式功能价值的需求,同时还可以保持一致的动态研究偏好。 The specific content involved in this section is as follows: Modeling the reward shows the explicit reward of modeling the implicit reward for modeling the results rewarding the rewarding process of modeling iterative learning with the adaptive reward that optimizes Optimizing Optimizing Optimizing Optimizationsa pag-optimize (PPO) sa LLM batay sa pag-aaral ng feedback ng feedback (RLHF na pag-optimize ng lugar NG反馈(。 (Chinchilla)和模型压缩(GPTQ)以提高性能和可伸缩性。PLE旋转)基于对偏好的微调以及SFT SFT LLM框架和正方形的对齐方式的细田调谐(专业)良好的裂纹(专业)较小的散布。研究微调模型方法研究的测试测试方法,而测试时间延长(TTS)通常会在构想过程中提高模型功能,这不需要模型更新。图5显示了TTS方法的分类状况 - 它是根据其基础技术进行分类的。具体而言,以下方法包括:最佳搜索到N搜索(拒绝抽样)的群集计算出最佳的扩展思想链自我回波链,并通过对树的思维(停止)地图思维(基于思想的图形)进行解码来计算基于采样搜索搜索验证器的验证器,并通过优化Monte Carlo搜索(MCTS)和测试和测试的方法6比较6比较LLM 6.提示的直接过程(输入输入W在更结构化的过程中进行推理)。思维链(COT)引入了逐步推理,而自矛盾(COT-SC)则是产生许多COT路径并选择最常见的答案。 Mutiple COT能够团结起来探索不同的理解途径。思想树(TOT)是树的原因,这是通过动态 - 新的集成和连接思维的思维图(got)来实现回溯和精致的原因。 LLM后训练基准测试以评估在后LLM培训阶段的性能,在许多领域都提出了许多基准:推理强化学习对齐对齐多语言评估普遍理解对话对话以及对框架的搜索分析,确保对LLM和LLM限制的益处进行全面了解。这些基准测试在LLM后处理阶段起重要作用,在该阶段,模型进行了正确的,校准,对齐和优化,以提高精确度y反应,稳定和道德依从性。本节合并 - 介绍主要基准。由NoteTake描述这些基准组下的主要数据集。在最终方向上,作者团队还收集了与后LLM训练方法相关的论文,并审查了它们的趋势,如图7所示。可以看出,自2020年以来,增强措施的研究大大改善了LLM(图7A),这也具有对诸如人类计算机互动等交互方法的需求。同时,由于出现了奖励语言模型,对奖励奖励的兴趣(图7b)也继续增加,但是该领域仍在努力处理奖励黑客问题,并设计解决稳定的奖励功能,这些奖励功能解决了稳定,引起注意的黑客问题。解码和搜索技术(图7C)包括蒙特卡洛的思维和方法,其目的是通过迭代自我批评来增强推理能力,但是这些方法S还需要可靠的不确定性估计来防止过度的计算开销。安全性,稳定性和解释性已成为主要问题(图7D),并且朝这个方向的研究人员提高了意识和意识到超出人类不确定性关系以外的研究方法的意识可以保持用户信心并防止攻击者的攻击。个性化和灵活性(图7E)也是主要的地方 - 当LLMS定制针对特定领域定制时,应权衡隐私风险,尤其是在公司数据或敏感的个人信息方面。 SAMDEAR是奖励优化的过程和结果(图7F)仍然是一个悬而未决的问题:虽然基于过程的奖励有助于指导渐进式改进,但以结果为中心的指标更简单,但不能获得关键决策。除了奖励结构外,仍然存在诸如灾难性健忘和违反数据的问题,当新的活动,强调了对参数和隐私保护技术(例如隐私多样性和联合研究)的需求。尽管人类反馈处于对齐的中间,但它很昂贵并且范围有限。诸如宪法AI和RLAIF之类的方法希望偏见和自我模型的部分管理自动化。最后,测试时间和动态推理框架的扩展也显示出其他挑战:模型应该知道何时将更多计算分配给复杂的查询,如何有效调整验证模块以及如何在对手输入前保持稳定的性能。研究整合的方向(涵盖奖励建模,解码技术,可解释性,个性化和安全维修)具有各种LLM强化学习角色,并共同塑造了大规模语言模型开发的未来轨迹。

如今,培训后的技术(例如维修和增强研究)已成为提高LLM功能的重要关键。最近,一份后LLM培训审查报告获得了许多赞美,其用于分类的相关论文和工具的资源库已获得了700多颗恒星。 The review comes from various institutions including the UAE University of Artificial Intelligence, the University of Central Florida, Google Deepmind, and Oxford, which covers technologies that enhance LLM by studying reinforcement, administering fine-expanding, test-to-test-expansion, and testing of post---------------------------language training.纸张标题:LLM验证训练:大型语言模型推理的深入潜水:https://arxiv.org/abs/2502.21321资源库:https://github.com/mbzuai-ysomex/awsome-some-loweshome-awesome-awsome-lawsome-llm-post-post-训练机器在内容和内容上累积了一份内容。有关更多详细信息,请访问上面的链接。在rec多年来,大语言模型(LLM)的功能继续改善,应用领域也迅速扩大。尽管如此,仍然存在问题。例如,LLM可能具有这样的“幻觉”,即产生错误的内容或不正确的事实;在更长的会议上保持逻辑一致性也可能很难。此外,LLM中推理的概念仍然是一个高度辩论的主题。尽管理解模型可能会提供看似合乎逻辑的相互关联的响应,但它们的推理与作为人的逻辑推理不同。这种差异很重要,因为Nakit有助于解释为什么LLM在执行引人注目的输出时仍在与相对简单的逻辑作品作斗争。与操纵明确的政策和事实的象征性推理不同,LLM以隐式和概率的方式运作。在本综述报告中,LLM的“推理”是指基于统计模式的逻辑相互关联回答的形成在数据中,而不是明确的逻辑推理或符号操作。此外,在接下来的代币预测中训练的模型可能与用户期望或道德标准不符,尤其是在模糊或恶意情况下。这些问题表明,还需要专门的技术来解决LLM输出的可靠性,偏见和上下文敏感性问题。训练的过程几乎可以分为两个阶段:训练前和训练后。训练前阶段通常取决于下一个标记,从而预测目标的大规模语料库,而训练后阶段通常涉及许多精细修复和比对的旋转。训练后机制的目的是改善模型的行为,并通过优化模型行为来与人类意图(包括降低偏见和不准确)保持一致。为了使LLM适应某些活动领域,通常涉及诸如微调之类的方法。尽管这些技术CAn用于特定任务,但也存在过度拟合的风险,并且还具有高计算成本。为了解决这些困难,引入了加强研究(RL)。这使Modelo可以使用动态反馈和优化的决策来提高灵活性。此外,通过搜索(RAG)增强的缩放技术,包括低级别适应性(LORA),适配器和世代,还可以提高计算效率和现实的准确性。这些策略与共享培训框架结合使用,促进了大规模扩展,并进一步提高了各种应用中LLM的可用性,请参见下面的图1。通过针对性的训练后技术,LLM可以更好地与人类的意图和道德道德要求保持一致,这最终可以提高其在现实世界中的可用性。关键的训练后阶段摘要下面。该安排是为了使预训练的LLM适应特定的任务或字段,并具体方法是根据所选数据集更新参数。尽管在规模上进行培训的LLM通常具有良好的总体能力,但微调也可以增强其在特定活动中的能力,包括感性分析,问答和医学诊断。通常对此过程进行管理,这与模型与任务要求保持一致,但也带来了诸如过度拟合,高计算成本和数据偏见敏感性之类的困难。为此,诸如Lora和适配器之类的良好参数可以通过更新显式参数来找出特定任务,从而大大降低计算开销。尽管这些模型是专家,但他们可能会遇到外部外部暴力困难,为此,他们需要权衡模型的专业素养或使用。研究传统强化研究环境的强化,代理必须与结构化环境相互作用,采取离散的行动在状态之间,并最大程度地提高合并的-a-奖励。适合加固研究的领域应具有确定的状态 - 行动空间和明确的目标,例如机器人,棋盘游戏和控制系统。在LLM领域的加固研究是不同的。 LLM不是从有限的一组动作中选择的,而是从大型词汇中选择的,它们的新兴状态由成长的文本文本组成。这样,信贷的计划和提供将变得复杂,因为令牌选择的效果通常直到最后才出现。此外,基于语言的增强反馈的特征是稀疏,主观和延迟,因此通常依赖于启发式检查和用户偏好而不是明确的性能指标。与通常用于单一目的进行优化的传统加固研究不同,LLM还应平衡许多目标。一种结合基于过程的奖励的混合方法(例如推理之王)通过结果评估(例如,质量反应)有助于改善研究结果。因此,LLM增强研究需要特殊的优化技术来处理高维输出,不稳定的状态目标和复杂性结构,以确保响应保持上下文并与用户期望保持一致。扩展对于提高LLM的性能和效率至关重要。这将有助于提高活动中模型的整体模型的性能,但也可以带来重大的计算挑战。为了平衡绩效和资源效率,在推理时必须针对目标。诸如思想链(COT)推理和对树(TOT)框架的思考之类的方法通过在分步或类似结构中破坏复杂问题来增强推理的许多步骤。此外,基于搜索的技术可以迭代地探索可能的输出,有助于改善响应并确保REA的准确性提高爱。这些技术,结合了洛拉,适配器和抹布等方法,可以提高模型处理复杂的,特定领域的大型任务的能力。抹布可以通过动态新知识来提高精度,从而减轻静态培训数据限制。共享的培训框架可以利用并行处理来管理大型模型的高计算要求。测试时间延长可能会根据任务的复杂性来调整参数以优化识别。改变深度,宽度或活动层可以平衡计算效率和输出质量,以适应资源有限或可变的条件。尽管按比例抑制了颠簸,但仍然存在挑战,例如减少回报,更长的理解时间和环境影响,尤其是在测试过程中执行搜索技术而不是训练时。以高质量和良好的质量部署LLM,以确保访问D可行性很重要。背景信息审查报告的第二部分介绍了与后LLM培训有关的背景信息,包括基本的正式描述,基于加强研究的订单推理以及早期刺激语言建模方法。但是我们在这里跳过了,请查看原始报告以获取详细信息。表1提供了最近的模型的一般性 - 包括其参数,架构类型和所使用的蒸馏RL方法。图2总结了LLM推理方法,该方法显示了通过提示链(COT)提示,自回馈和情节记忆来增强推理能力的方法。它还展示了各种基于研究的优化技术,包括GRPO,RLHF,DPO和RLAIF。从一种过程中,加强律师事务所将增强措施整合到LLM推理的研究中,通常遵循以下基本步骤:1。微调管理(SFT):从前活语言开始DEL,在包含高质量的人造样品样本的管理数据集中的精细建模模型。此阶段确保模型获得符合格式和样式的基线。 2。模型模型(RM)训练:收集通过微调模型产生的输出并执行手动偏好。然后,对奖励模型进行训练以复制标签或基于等级的标记,从而有效地学习持续的奖励功能,该功能将文本响应映射到标量值。 3。研究研究研究研究:最后,通过策略梯度算法(例如PPO)优化基本语言模型,以最大程度地提高奖励模型的输出。通过避免通过此循环,LLM可以意识到在性,有用性和风格连贯性等基本方面有利于人类的更多响应的准确性。 4。维修和对齐的奖励:发展复杂的奖励功能(从人类的偏好,对抗反馈或自动措施中汲取),以指导ANG模型,以获得连贯,安全,安全,适当的上下文适当。在理解许多步骤的过程中,有效地提供信贷,这些奖励很重要。在早期,人类偏好的LLM研究算法是经典的算法,例如PPO和自信域(TRPO),这是通过最大化预期的合并 - 与 - 奖励和KL不同的优化技术。在这些过程中的改进后继者,例如直接偏好优化(DPO)和小组相对策略优化(GRPO),已经基于偏好而进行了可扩展优化。这些程序重新表达目标对准作为基于偏好数据标记人的维修的损失函数。与PPO和TRPO不同,依赖于明确的奖励模型和审查网络,DPO和GRPO使用对数加不出的比率以及删除组比较分别直接优化技术,以消除对显式功能价值的需求,同时还可以保持一致的动态研究偏好。 The specific content involved in this section is as follows: Modeling the reward shows the explicit reward of modeling the implicit reward for modeling the results rewarding the rewarding process of modeling iterative learning with the adaptive reward that optimizes Optimizing Optimizing Optimizing Optimizationsa pag-optimize (PPO) sa LLM batay sa pag-aaral ng feedback ng feedback (RLHF na pag-optimize ng lugar NG反馈(。 (Chinchilla)和模型压缩(GPTQ)以提高性能和可伸缩性。PLE旋转)基于对偏好的微调以及SFT SFT LLM框架和正方形的对齐方式的细田调谐(专业)良好的裂纹(专业)较小的散布。研究微调模型方法研究的测试测试方法,而测试时间延长(TTS)通常会在构想过程中提高模型功能,这不需要模型更新。图5显示了TTS方法的分类状况 - 它是根据其基础技术进行分类的。具体而言,以下方法包括:最佳搜索到N搜索(拒绝抽样)的群集计算出最佳的扩展思想链自我回波链,并通过对树的思维(停止)地图思维(基于思想的图形)进行解码来计算基于采样搜索搜索验证器的验证器,并通过优化Monte Carlo搜索(MCTS)和测试和测试的方法6比较6比较LLM 6.提示的直接过程(输入输入W在更结构化的过程中进行推理)。思维链(COT)引入了逐步推理,而自矛盾(COT-SC)则是产生许多COT路径并选择最常见的答案。 Mutiple COT能够团结起来探索不同的理解途径。思想树(TOT)是树的原因,这是通过动态 - 新的集成和连接思维的思维图(got)来实现回溯和精致的原因。 LLM后训练基准测试以评估在后LLM培训阶段的性能,在许多领域都提出了许多基准:推理强化学习对齐对齐多语言评估普遍理解对话对话以及对框架的搜索分析,确保对LLM和LLM限制的益处进行全面了解。这些基准测试在LLM后处理阶段起重要作用,在该阶段,模型进行了正确的,校准,对齐和优化,以提高精确度y反应,稳定和道德依从性。本节合并 - 介绍主要基准。由NoteTake描述这些基准组下的主要数据集。在最终方向上,作者团队还收集了与后LLM训练方法相关的论文,并审查了它们的趋势,如图7所示。可以看出,自2020年以来,增强措施的研究大大改善了LLM(图7A),这也具有对诸如人类计算机互动等交互方法的需求。同时,由于出现了奖励语言模型,对奖励奖励的兴趣(图7b)也继续增加,但是该领域仍在努力处理奖励黑客问题,并设计解决稳定的奖励功能,这些奖励功能解决了稳定,引起注意的黑客问题。解码和搜索技术(图7C)包括蒙特卡洛的思维和方法,其目的是通过迭代自我批评来增强推理能力,但是这些方法S还需要可靠的不确定性估计来防止过度的计算开销。安全性,稳定性和解释性已成为主要问题(图7D),并且朝这个方向的研究人员提高了意识和意识到超出人类不确定性关系以外的研究方法的意识可以保持用户信心并防止攻击者的攻击。个性化和灵活性(图7E)也是主要的地方 - 当LLMS定制针对特定领域定制时,应权衡隐私风险,尤其是在公司数据或敏感的个人信息方面。 SAMDEAR是奖励优化的过程和结果(图7F)仍然是一个悬而未决的问题:虽然基于过程的奖励有助于指导渐进式改进,但以结果为中心的指标更简单,但不能获得关键决策。除了奖励结构外,仍然存在诸如灾难性健忘和违反数据的问题,当新的活动,强调了对参数和隐私保护技术(例如隐私多样性和联合研究)的需求。尽管人类反馈处于对齐的中间,但它很昂贵并且范围有限。诸如宪法AI和RLAIF之类的方法希望偏见和自我模型的部分管理自动化。最后,测试时间和动态推理框架的扩展也显示出其他挑战:模型应该知道何时将更多计算分配给复杂的查询,如何有效调整验证模块以及如何在对手输入前保持稳定的性能。研究整合的方向(涵盖奖励建模,解码技术,可解释性,个性化和安全维修)具有各种LLM强化学习角色,并共同塑造了大规模语言模型开发的未来轨迹。